这是一个非常典型的“PNC(规控)选手误入CV(计算机视觉)深水区”的课表。

作为PNC架构师,我必须敲醒你:李沐老师的课虽然是神课,但他是讲CV和NLP通用的。如果你全看,至少浪费50%的时间。 对于PNC算法岗,你的核心战场是“时序预测”和“决策逻辑”,而不是教车子怎么“看图”。

以下是基于PNC高薪Offer标准的剪裁版学习指南:

第一部分:绝对核心区 (必修 - 死磕)

优先级:S+ 理由:这是现代自动驾驶Prediction(预测)和End-to-End Planning(端到端规划)的基石。不懂这个,你只能做传统的规则代码,拿不到顶薪。

- 7月17日 - 7月18日:序列模型、RNN

- PNC视角:把课程里的“文本/单词”自动脑补替换成“车辆历史轨迹点 (x, y, v, a)”。预测旁车未来3秒怎么走,本质上就是个语言模型(Next Token Prediction)。

- 7月25日:GRU、LSTM

- 面试考点:LSTM怎么解决梯度消失的?在轨迹预测(Social-LSTM)里怎么用?

- 要求:手写代码。弄懂Input/Output的维度。

- 8月7日:Seq2Seq、Encoder-Decoder、束搜索 (Beam Search)

- PNC视角:这是轨迹生成的标准架构。输入过去5秒轨迹(Encoder),输出未来5秒轨迹(Decoder)。

- 实战痛点:Beam Search用于生成多模态轨迹(比如预测前车可能直行,也可能左转,这是两条不同的Beam)。

- 8月8日:注意力机制 (Attention)

- PNC视角:核心中的核心。用于处理交互 (Interaction)。比如:自车在规划时,应该关注左边的车还是右边的车?Attention Score告诉你答案。

- 8月14日 - 8月15日:Transformer、BERT

- 判决:学死它。

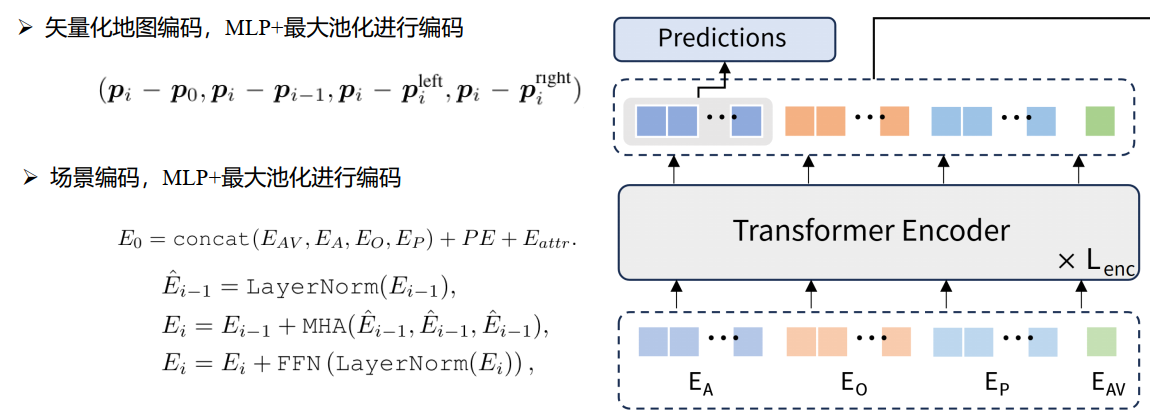

- 理由:现在的SOTA预测模型(如VectorNet, TNT)和端到端规划(UniAD)全是Transformer架构。面试必问 Self-Attention 的 $O(n^2)$ 复杂度怎么优化。

第二部分:上下游常识区 (选修 - 速通概念)

优先级:A 理由:PNC的输入是Perception发来的。你不需要会写检测算法,但你必须懂“输入数据”的特性,才能在规划层做鲁棒性处理(Safety Shield)。

- 6月27日:物体检测基础 (边缘框、锚框)

- PNC视角:你需要懂 Bounding Box (bbox)。

- 痛点:感知发给你的bbox经常会抖动(跳变)。如果你不懂IOU(交并比)和NMS(非极大值抑制),你就不知道怎么在规划层过滤这些噪声。

- 7月3日:YOLO vs R-CNN

- PNC视角:只看实时性对比。

- 考点:为什么车端常用YOLO(快,One-stage)而不用R-CNN?因为规控需要感知在30ms内给结果。

- 7月10日:语义分割

- PNC视角:懂概念即可。

- 理由:语义分割的输出就是PNC里的Costmap(代价地图)或可行驶区域 (Drivable Area)。你要知道这个东西是怎么来的,边缘为什么会不准。

- 8月21日:优化算法

- PNC视角:SGD, Adam。虽然PNC主要用QP/SQP求解器,但深度学习优化器的思想(动量、梯度下降)对理解非凸优化有帮助。

第三部分:垃圾时间 (跳过 - 别浪费生命)

优先级:C (Direct Pass) 理由:这是CV算法岗或者Infra架构师的活,PNC看了没用。

- 6月19日:多GPU训练、分布式

- 判决:[跳过]

- 理由:除非你去搞自动驾驶云端训练平台。

- 6月20日:图像增广

- 判决:[跳过]

- 理由:这是感知的活。规划的增广是对轨迹做扰动,不是对图片做旋转/裁剪。

- 6月26日:Kaggle 图像分类实战

- 判决:[跳过]

- 理由:纯CV比赛,对PNC无加分。

- 7月11日:样式迁移 (Style Transfer)

- 判决:[跳过]

- 理由:那是搞滤镜App用的,车不需要画梵高风格的画。

- 7月4日:多尺度检测实现、SSD实现

- 判决:[跳过]

- 理由:实现细节太繁琐,面试不考规控人员手写SSD Loss。

导师的“一针见血”总结

你的学习路径应该是这样的:

- 略过前面的CV卷积部分(知道卷积是提特征的就行)。

- 空降到 7月17日 (RNN) 开始认真学。

- 死磕 Transformer 及其变体。

- 思维转换:每当李沐老师说“单词”时,你脑子里要自动替换成“(x, y)”;每当他说“句子”时,你替换成“轨迹”。

下一步建议: 学完 Transformer 后,不要去微调 BERT 做文本分类。 直接去找一篇自动驾驶轨迹预测的经典论文(比如 VectorNet 或 Trajectron++)的代码读一下,看看他们是怎么用 LSTM/Transformer 处理 (x,y) 坐标序列的。这才是把你学到的东西变现的唯一路径。

Bold

Bold